Bạn đã bao giờ sử dụng ChatGPT, Claude hay các công cụ viết content AI khác và tự hỏi: Tại sao lúc thì nó trả lời cực kỳ chính xác, lúc thì lại 'ảo giác' viết ra những thứ trên trời dưới biển?

.

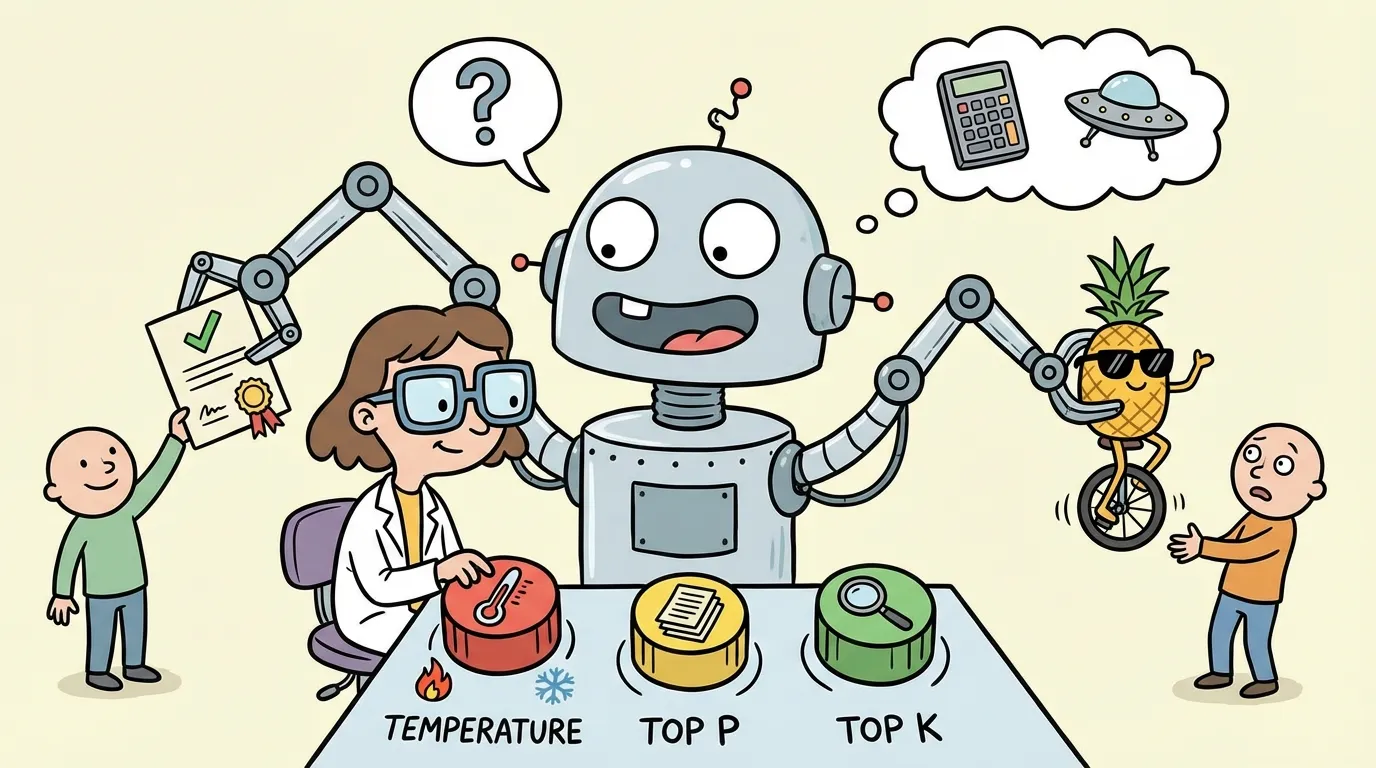

Câu trả lời không nằm ở việc AI thông minh

hay ngốc nghếch

đột xuất, mà nằm ở cách chúng ta cài đặt các núm vặn

điều khiển đầu ra của nó. Ba núm vặn

quan trọng nhất quyết định sự cân bằng giữa tính chính xác và sự sáng tạo của AI chính là Temperature, Top P và Top K.

Trong bài viết này, chúng ta sẽ cùng đi sâu vào tìm hiểu các khái niệm này một cách đơn giản, dễ hiểu nhất để bạn có thể hoàn toàn làm chủ AI.

Tại sao cần điều chỉnh các tham số này khi dùng AI?

Các Mô hình Ngôn ngữ Lớn (LLMs) như GPT-4 không thực sự hiểu

văn bản như con người. Về cơ bản, chúng là những cỗ máy dự đoán xác suất cực kỳ phức tạp.

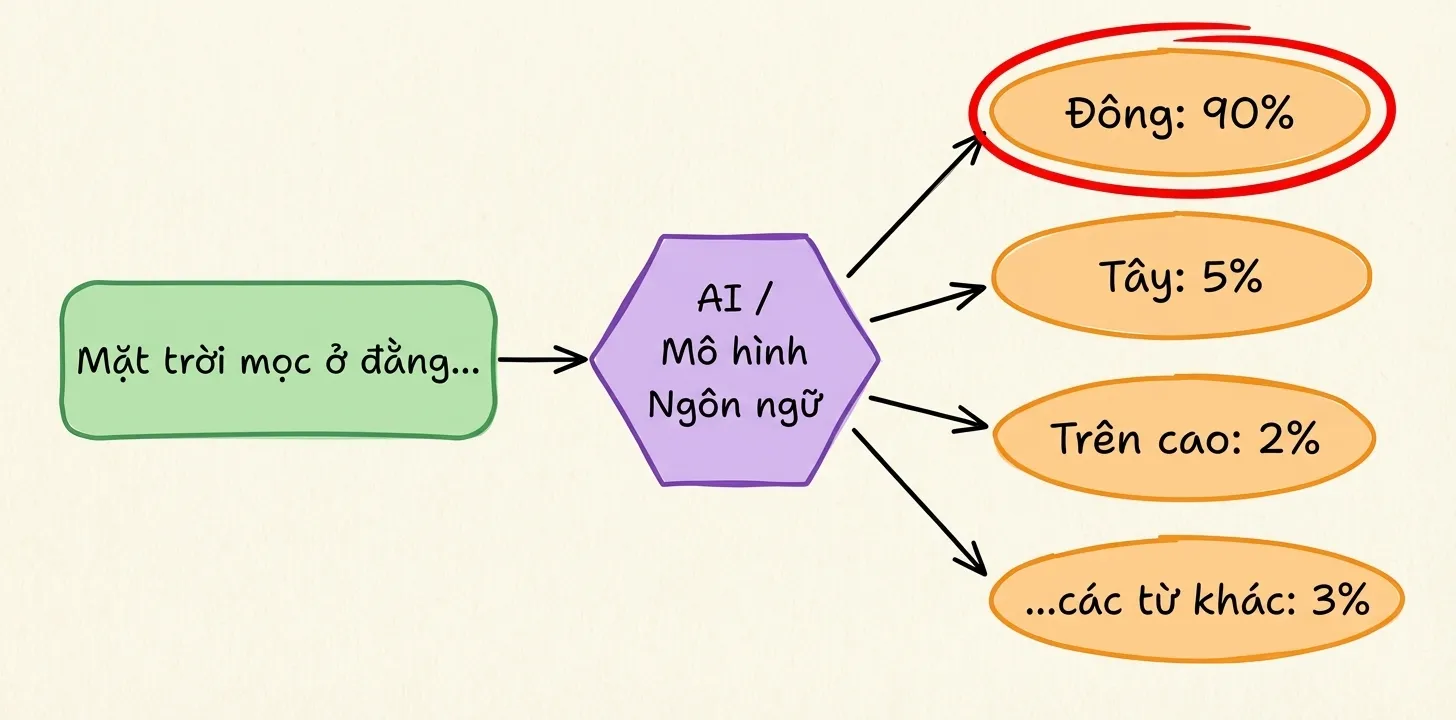

Khi bạn đưa ra một câu gợi ý (prompt), nhiệm vụ duy nhất của AI là đoán xem từ tiếp theo nên là gì.

Ví dụ, nếu prompt là: Mặt trời mọc ở đằng...

, AI sẽ tính toán xác suất cho từ tiếp theo:

1

2

3

4

Đông: 90%

Tây: 5%

Trên cao: 2%

...các từ khác: 3%

Nếu AI luôn luôn chọn từ có xác suất cao nhất (ở đây là Đông

), nó sẽ rất chính xác nhưng nhàm chán và lặp đi lặp lại. Ngược lại, nếu thỉnh thoảng nó chọn những từ có xác suất thấp (như Tây

), nó sẽ trở nên sáng tạo

hơn, nhưng cũng dễ sai sự thật hơn (ảo giác AI).

Các tham số Temperature, Top P và Top K chính là công cụ để bạn bảo AI biết khi nào nên an toàn và khi nào nên mạo hiểm.

Temperature là gì?

Temperature (Nhiệt độ) là tham số phổ biến nhất để kiểm soát tính ngẫu nhiên của đầu ra AI. Hãy tưởng tượng nó như một thanh trượt điều chỉnh độ điên rồ

hoặc sáng tạo

của mô hình.

Giá trị Temperature thường nằm trong khoảng từ 0 đến 1 (một số mô hình cho phép lên đến 2).

Temperature thấp (Gần 0)

Cơ chế: Khi temperature thấp, AI trở nên rất bảo thủ. Nó làm cho các từ có xác suất cao trở nên vượt trội hơn nữa, và các từ xác suất thấp gần như bị loại bỏ. AI sẽ gần như luôn chọn từ có khả năng xảy ra cao nhất.

Kết quả: Đầu ra rất nhất quán, chính xác, thực tế, và ít sáng tạo. Câu trả lời thường ngắn gọn và đi thẳng vào vấn đề.

Khi nào nên dùng:

- Khi cần câu trả lời thực tế, chính xác (ví dụ: tra cứu thông tin, giải toán).

- Khi viết code (lập trình đòi hỏi sự chính xác tuyệt đối).

- Khi cần sự nhất quán (hỏi cùng một câu nhiều lần sẽ nhận được cùng một câu trả lời).

Ví dụ dễ hiểu:

Hỏi AI: “Trả lời nhanh thủ đô Việt Nam tên gì?”

Temperature = 0.0

→ AI trả lời:

Thủ đô của Việt Nam là Hà Nội.

Hỏi lại 10 lần → vẫn là Hà Nội, không vòng vo.

Kết quả:

Đầu ra rất nhất quán, chính xác, thực tế, và ít sáng tạo. Câu trả lời thường ngắn gọn và đi thẳng vào vấn đề.

Temperature cao (Gần 1 hoặc hơn)

Cơ chế: Khi temperature cao, sự chênh lệch giữa từ có khả năng cao nhất và các từ khác bị thu hẹp lại. Các từ hiếm gặp giờ đây có cơ hội cao hơn để được chọn.

Kết quả: Đầu ra đa dạng hơn, sáng tạo hơn, bất ngờ hơn, nhưng cũng dễ lan man và có nguy cơ ảo giác

(bịa thông tin) cao hơn.

Khi nào nên dùng:

- Viết sáng tạo (thơ, truyện, kịch bản).

- Brainstorm ý tưởng mới.

- Khi bạn muốn AI

nói nhiều

và bay bổng hơn.

Ví dụ dễ hiểu:

Cũng câu hỏi đó: Trả lời nhanh thủ đô Việt Nam tên gì?

Temperature = 2.0

→ AI có thể trả lời:

Thủ đô của Việt Nam hiện nay là Hà Nội. Hà Nội là trung tâm văn hóa, kinh tế, giáo dục và chính trị của cả nước.

Hỏi lại lần nữa →

Hà Nội là thủ đô của nước Cộng hòa xã hội chủ nghĩa Việt Nam. Đây là thành phố trực thuộc trung ương và là một trong hai đô thị loại đặc biệt của Việt Nam. Hà Nội là trung tâm chính trị, văn hóa, giáo dục và là một trong hai trung tâm kinh tế quan trọng của Việt Nam.

Thông tin vẫn đúng, nhưng cách nói khác hẳn.

Kết quả:

Đầu ra đa dạng hơn, sáng tạo hơn, bất ngờ hơn, nhưng cũng dễ lan man và có nguy cơ ảo giác

(bịa thông tin) cao hơn.

Top P là gì?

Nếu Temperature quyết định AI “liều tới mức nào”, thì Top P quyết định AI được phép liều trong phạm vi nào.

Top P (còn gọi là nucleus sampling) không làm thay đổi xác suất của các từ, mà chỉ chọn ra một nhóm từ đủ tốt, sau đó AI chỉ được chọn trong nhóm đó.

Top P hoạt động như thế nào?

Top-p là cách chọn token tiếp theo dựa trên nhóm token có tổng xác suất đạt ít nhất p.

Ý tưởng đơn giản

- Model dự đoán xác suất cho tất cả token có thể xảy ra tiếp theo.

- Sắp xếp token theo xác suất giảm dần.

- Lấy từ trên xuống cho đến khi tổng xác suất cộng dồn >= p → đây gọi là “nucleus”.

- Chỉ chọn ngẫu nhiên trong nhóm nucleus đó (không chọn ngoài nhóm).

Ví dụ dễ hiểu

Giả sử model đang viết câu: “Hôm nay trời …”

Và xác suất token tiếp theo là:

1

2

3

4

5

6

7

- "đẹp" : 0.40

- "mưa" : 0.25

- "lạnh" : 0.15

- "nóng" : 0.10

- "xấu" : 0.05

- "gắt" : 0.03

- (các token khác) : 0.02

Nếu Top P = 0.80

Cộng dồn từ lớn tới nhỏ:

đẹp

0.40 (tổng 0.40)mưa

0.25 (tổng 0.65)lạnh

0.15 (tổng 0.80) → đạt 0.80

→ Nucleus = {đẹp

, mưa

, lạnh

}

Model sẽ chọn ngẫu nhiên chỉ trong 3 từ này, theo tỉ lệ xác suất của chúng.

Nếu Top P = 0.95

Cộng dồn:

đẹp

0.40 (tổng 0.40)mưa

0.25 (tổng 0.65)lạnh

0.15 (tổng 0.80)nóng

0.10 (tổng 0.90)xấu

0.05 (tổng 0.95) → đạt 0.95

→ Nucleus = {đẹp

, mưa

, lạnh

, nóng

, xấu

}

Nhiều lựa chọn hơn, câu có thể đa dạng hơn, đôi khi lạ hơn.

Tóm lại ngắn gọn về Top P

- Top P thấp (ví dụ 0.3–0.5): ít lựa chọn → ổn định, ít lan man.

- Top P cao (ví dụ 0.8–0.95): nhiều lựa chọn → sáng tạo hơn, nhưng dễ bốc đồng.

Top K là gì?

Top-k là cách chọn token tiếp theo bằng cách:

- Model dự đoán xác suất cho tất cả token

- Chỉ giữ lại K token có xác suất cao nhất

- Random chọn trong K token đó (theo xác suất đã chuẩn hoá)

Top-k = “chỉ cho phép chọn trong top K lựa chọn phổ biến nhất.”

Ví dụ dễ hiểu

Giả sử model đang viết: “Hôm nay trời …”

Xác suất token tiếp theo:

1

2

3

4

5

6

7

- "đẹp" : 0.40

- "mưa" : 0.25

- "lạnh" : 0.15

- "nóng" : 0.10

- "xấu" : 0.05

- "gắt" : 0.03

- (khác) : 0.02

Nếu Top K = 3

Giữ lại 3 token xác suất cao nhất:

đẹp

: 0.40mưa

: 0.25lạnh

: 0.15

→ Model chỉ được chọn trong {đẹp

, mưa

, lạnh

}

Các token như nóng

, xấu

, gắt

bị loại bỏ hoàn toàn.

Nếu Top K = 5

Giữ lại:

đẹp

: 0.40mưa

: 0.25lạnh

: 0.15nóng

: 0.10xấu

: 0.05

→ Nhiều lựa chọn hơn → câu đa dạng hơn, nhưng vẫn trong “vùng phổ biến”.

Top-k khác top-p chỗ nào?

- Top K: luôn giữ đúng K token, dù phân phối xác suất có “tập trung” hay “tản” cỡ nào.

- Top P: số token giữ lại thay đổi linh hoạt để tổng xác suất >= p.

So sánh Temperature – Top P – Top K

| Tham số | Hiểu nhanh | Ảnh hưởng chính | Thấp thì sao? | Cao thì sao? |

|---|---|---|---|---|

| Temperature | Độ “liều” của AI | Mức sáng tạo / ngẫu nhiên | Cứng, an toàn, rất logic | Bay, sáng tạo, dễ lan man |

| Top P | Phạm vi từ được phép chọn | Độ linh hoạt khi chọn từ | Chặt chẽ, ít lệch | Tự nhiên hơn, đa dạng |

| Top K | Số từ tối đa AI được chọn | Độ rộng lựa chọn mỗi bước | Ít lựa chọn, câu rất cứng | Nhiều lựa chọn, dễ sáng tạo |

Tóm lại

- Temperature: AI có được phép liều không?

- Top P: AI được dùng bao nhiêu % từ hợp lý nhất?

- Top K: AI được nhìn bao nhiêu từ để chọn?

Ví dụ tổng hợp về Temperature, Top P, Top K

Câu: “Cuối tuần này tôi muốn đi …”

Xác suất:

1

2

3

4

5

- chơi (0.30)

- du lịch (0.25)

- nghỉ ngơi (0.20)

- khám phá (0.12)

- trốn nợ (0.08)

- Temperature

- T = 0.3 → gần như luôn ra chơi

- T = 1.0 → du lịch / nghỉ ngơi

- T = 1.5 → có thể ra trốn nợ

- Top-p

- p = 0.7 → chơi, du lịch, nghỉ ngơi

- p = 0.9 → thêm: khám phá, trốn nợ

- Top-k

- k = 2 → chỉ chọn: chơi, du lịch

- k = 4 → thêm: nghỉ ngơi, khám phá

Preset nhanh theo mục đích

| Mục đích | Temperature | Top P | Top K |

|---|---|---|---|

| Code / kỹ thuật | 0.1 – 0.3 | 0.8 | 20 |

| Blog / SEO | 0.5 – 0.7 | 0.9 | 40 |

| Sáng tạo / ý tưởng | 0.9 – 1.2 | 1.0 | 50+ |

Kết luận

AI không hề “ảo” hay “kém đi” một cách ngẫu nhiên. Thứ quyết định chất lượng câu trả lời nằm ở cách bạn điều chỉnh Temperature, Top P và Top K. Tùy vào cách bạn thiết lập mà AI sẽ ưu tiên sáng tạo và dễ lan man, hoặc nó trở nên chính xác, ổn định và đúng mục đích. Hiểu ba tham số này đồng nghĩa với việc bạn không còn phụ thuộc vào may rủi, mà đang chủ động kiểm soát cách AI tạo ra câu trả lời.