ChatGPTやClaude、その他のAIライティングツールを使っていて、ふと疑問に思ったことはありませんか?「なぜ、すごく正確な回答をする時もあれば、とんでもない『幻覚(ハルシネーション)』のような内容をでっち上げる時があるのだろう?」と。

その答えは、AIが急に「賢く」なったり「馬鹿」になったりするからではありません。私たちがAIの出力をコントロールするための「調整ノブ」の設定にあるのです。AIの「正確さ」と「創造性」のバランスを決定づける最も重要な3つの「ノブ」、それが Temperature(温度)、Top P、そして Top K です。

この記事では、あなたがAIを完全に使いこなせるように、これらの概念を最もシンプルで分かりやすく解説していきます。

なぜAIを使う時にこれらのパラメータ調整が必要なのか?

GPT-4のような大規模言語モデル(LLM)は、人間のように文章を「理解」しているわけではありません。基本的には、極めて複雑な「確率予測マシン」に過ぎないのです。

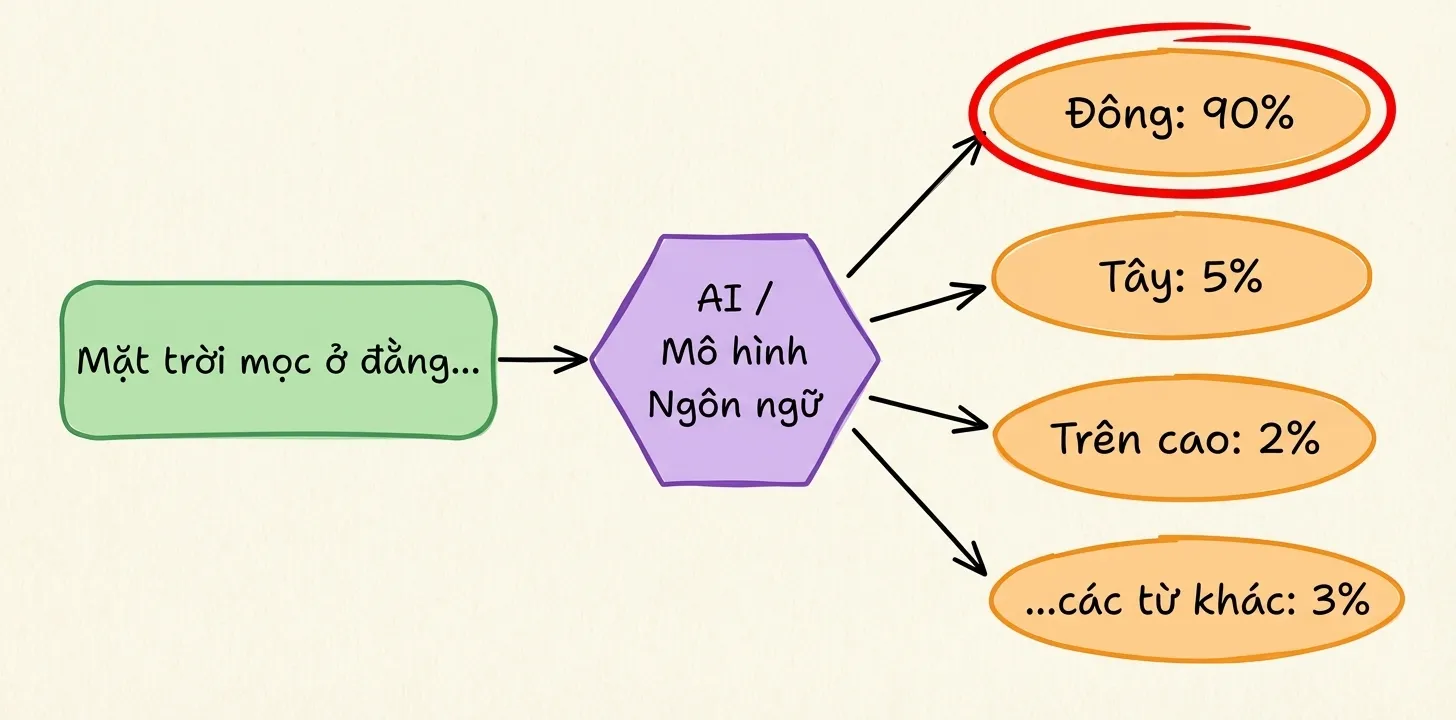

あなたがプロンプト(指示文)を入力したとき、AIの唯一の任務は「次に続く単語は何か?」を予測することです。

例えば、「太陽は...から昇る」というプロンプトがあった場合、AIは次の単語の確率を計算します。

1

2

3

4

東: 90%

西: 5%

上: 2%

...その他の単語: 3%

もしAIが常に最も確率の高い単語(ここでは「東」)だけを選び続ければ、非常に正確ですが、退屈で機械的な文章になります。逆に、時々確率の低い単語(「西」など)を選ぶようにすれば、より「創造的」にはなりますが、事実と異なること(AIの幻覚)を言うリスクも高まります。

Temperature、Top P、Top K というパラメータは、AIに対して「いつ安全策を取るべきか」「いつ冒険すべきか」を指示するためのツールなのです。

Temperature(温度)とは?

Temperatureは、AIの出力のランダム性を制御する最も一般的なパラメータです。モデルの「狂気度」や「創造性」を調整するスライダーだと想像してください。

Temperatureの値は通常 0 から 1 の範囲で設定します(一部のモデルでは 2 まで)。

Temperatureが低い場合(0に近い)

仕組み:Temperatureが低いと、AIは非常に保守的になります。確率の高い単語がより優先され、確率の低い単語はほぼ排除されます。AIはほぼ間違いなく、最も可能性の高い単語を選びます。

結果:出力は非常に一貫性があり、正確で、現実的ですが、創造性は低くなります。回答は簡潔で、要点を突いたものになりがちです。

使用すべき場面:

- 事実に基づいた正確な回答が必要な場合(例:情報検索、数学の問題)。

- コーディング(プログラミングには絶対的な正確さが求められるため)。

- 一貫性が必要な場合(同じ質問に対して常に同じ回答を得たい場合)。

分かりやすい例:

AIへの質問:「日本の首都はどこですか?手短に答えて。」

Temperature = 0.0

→ AIの回答:

日本の首都は東京です。

10回聞き直しても → 「東京です」と答え、ブレません。

結果:

出力は非常に一貫性があり、正確で、現実的ですが、創造性は低くなります。回答は簡潔で、要点を突いたものになりがちです。

Temperatureが高い場合(1に近い、またはそれ以上)

仕組み:Temperatureが高いと、最も可能性の高い単語とそれ以外の単語との差が縮まります。あまり使われない単語が選ばれるチャンスが増えるのです。

結果:出力はより多様で、創造的で、驚きのあるものになりますが、話が脱線したり、「幻覚」(嘘の情報)を生成したりするリスクも高まります。

使用すべき場面:

- クリエイティブな執筆(詩、小説、脚本)。

- 新しいアイデアのブレインストーミング。

- AIに「もっと語らせたい」、表現豊かにさせたい場合。

分かりやすい例:

同じ質問:「日本の首都はどこですか?手短に答えて。」

Temperature = 2.0

→ AIの回答:

現在、日本の首都として機能しているのは東京です。東京は政治、経済、文化、教育の中心地であり、世界でも有数の大都市圏を形成しています。

もう一度聞くと →

日本国憲法には首都を直接定める規定はありませんが、一般的に東京が首都とみなされています。皇居や国会議事堂、最高裁判所などの三権の長が所在する場所であり、日本の心臓部と言えるでしょう。

情報は正しいですが、言い回しが毎回異なります。

結果:

出力はより多様で、創造的で、驚きのあるものになりますが、話が脱線したり、「幻覚」(嘘の情報)を生成したりするリスクも高まります。

Top Pとは?

もし Temperature が「AIがどれだけリスクを冒すか」を決めるものだとしたら、Top P は 「AIがリスクを冒して良い範囲」 を決めるものです。

Top P(ニュークリアスサンプリングとも呼ばれます)は、単語の確率そのものを変えるのではなく、「十分に良い単語のグループ」を選抜し、AIはそのグループ内からのみ選択できるようにします。

Top Pはどのように機能するのか?

Top-p は、累積確率が少なくとも p に達するまでの単語グループに基づいて、次のトークン(単語)を選択する方法です。

シンプルな考え方

- モデルが次に続く可能性のあるすべてのトークンの確率を予測します。

- トークンを確率の高い順(降順)に並べます。

- 上から順に確率を足していき、合計が p 以上になるまでリストアップします。→ これを「ニュークリアス(核)」と呼びます。

- そのニュークリアスグループの中だけからランダムに選択します(グループ外からは選びません)。

分かりやすい例

モデルが「今日の天気は...」という文を書いているとします。

次のトークンの確率は以下の通りです:

1

2

3

4

5

6

7

- "良い" : 0.40

- "雨" : 0.25

- "寒い" : 0.15

- "暑い" : 0.10

- "悪い" : 0.05

- "酷い" : 0.03

- (その他) : 0.02

Top P = 0.80 の場合

確率の高い順に足していきます:

良い

0.40 (合計 0.40)雨

0.25 (合計 0.65)寒い

0.15 (合計 0.80) → 0.80に到達

→ ニュークリアス = {良い

, 雨

, 寒い

}

モデルはこの 3語の中だけ から、それぞれの確率に応じてランダムに選択します。

Top P = 0.95 の場合

足していきます:

良い

0.40 (合計 0.40)雨

0.25 (合計 0.65)寒い

0.15 (合計 0.80)暑い

0.10 (合計 0.90)悪い

0.05 (合計 0.95) → 0.95に到達

→ ニュークリアス = {良い

, 雨

, 寒い

, 暑い

, 悪い

}

選択肢が増え、文章がより多様になり、時には変わった表現が出ることもあります。

Top Pのまとめ

- Top P 低め(例 0.3–0.5):選択肢が少ない → 安定しており、脱線しにくい。

- Top P 高め(例 0.8–0.95):選択肢が多い → 創造的だが、突拍子もないことを言う可能性がある。

Top Kとは?

Top-k は、次のトークンを以下のように選択します:

- モデルがすべてのトークンの確率を予測します。

- 確率が最も高い K 個のトークンだけ を残します。

- その K 個のトークンの中から ランダムに選択します(確率は再計算されます)。

Top-k = 「人気トップ K の選択肢の中からしか選ばせない」

分かりやすい例

モデルが「今日の天気は...」と書いているとします。

次のトークンの確率:

1

2

3

4

5

6

7

- "良い" : 0.40

- "雨" : 0.25

- "寒い" : 0.15

- "暑い" : 0.10

- "悪い" : 0.05

- "酷い" : 0.03

- (その他) : 0.02

Top K = 3 の場合

確率上位3つのトークンを残します:

良い

: 0.40雨

: 0.25寒い

: 0.15

→ モデルは {良い

, 雨

, 寒い

} の中からしか選べません。

暑い

、悪い

、酷い

といったトークンは完全に除外されます。

Top K = 5 の場合

残すのは:

良い

: 0.40雨

: 0.25寒い

: 0.15暑い

: 0.10悪い

: 0.05

→ 選択肢が増え、文章は多様になりますが、あくまで「よくある表現」の範囲内に収まります。

Top-k と Top-p の違いは?

- Top K: 確率分布が「集中」していようが「分散」していようが、常に K個 のトークンを保持します。

- Top P: 確率の合計が p になるように、保持するトークンの数が 柔軟に変化 します。

Temperature – Top P – Top K の比較

| パラメータ | 一言で言うと | 主な影響 | 低いとどうなる? | 高いとどうなる? |

|---|---|---|---|---|

| Temperature | AIの「冒険心」 | 創造性 / ランダム性 | 硬い、安全、論理的 | 自由奔放、創造的、脱線しやすい |

| Top P | 選んで良い単語の範囲 | 単語選択の柔軟性 | 厳格、ブレが少ない | 自然、多様性がある |

| Top K | 選べる単語の最大数 | 選択肢の広さ | 選択肢が狭く、文章が硬い | 選択肢が多く、創造的になりやすい |

要約

- Temperature: AIにリスクを冒させても良いか?

- Top P: 妥当な単語の上位何%までを使って良いか?

- Top K: 選択候補としていくつの単語を見ても良いか?

Temperature, Top P, Top K の総合例

文:「今週末、私は...に行きたい」

確率:

1

2

3

4

5

- 遊び (0.30)

- 旅行 (0.25)

- 休憩 (0.20)

- 探検 (0.12)

- 高飛び (0.08)

- Temperature

- T = 0.3 → ほぼ確実に 遊び が選ばれる

- T = 1.0 → 旅行 や 休憩 も選ばれる

- T = 1.5 → 高飛び が選ばれるかもしれない

- Top-p

- p = 0.7 → 遊び、旅行、休憩 の中から選ぶ

- p = 0.9 → 追加で 探検、高飛び も候補に入る

- Top-k

- k = 2 → 遊び、旅行 のどちらかのみ

- k = 4 → 休憩、探検 も選択肢に入る

目的別クイックプリセット

| 目的 | Temperature | Top P | Top K |

|---|---|---|---|

| コード生成 / 技術系 | 0.1 – 0.3 | 0.8 | 20 |

| ブログ記事 / SEO | 0.5 – 0.7 | 0.9 | 40 |

| クリエイティブ / アイデア出し | 0.9 – 1.2 | 1.0 | 50+ |

結論

AIは決してランダムに「幻覚」を見たり「劣化」したりしているわけではありません。回答の質を決めるのは、あなたがどのように Temperature、Top P、Top K を調整するかにかかっています。設定次第で、AIは創造性を優先して話を広げることもあれば、正確で安定した目的通りの回答をすることもあります。これら3つのパラメータを理解するということは、運任せにするのではなく、AIがどのように回答を生成するかを主体的にコントロールできるようになるということです。